Je gebruikt misschien AI bij het notuleren, bijvoorbeeld om een vergadering te analyseren.

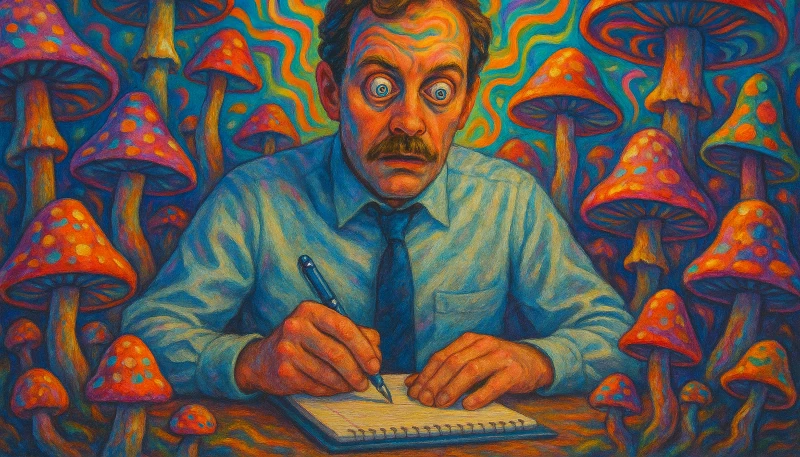

Dan verwacht je ook dat AI goed en nauwkeurig werkt. Toch gaat het fout zodra je verkeerde aannames invoert bij Copilot of ChatGPT.

Voorbeeld: je stelt een vraag die al een conclusie bevat. Zoals: "Welke discussie is er in dit agendapunt gevoerd?"

terwijl er helemaal geen discussie was in het agendapunt.

AI spreelkt je dan niet tegen. In plaats van jouw onjuiste aanname te benoemen of te corrigeren, geeft AI een antwoord dat aansluit bij je vraag.

Dit komt door hoe AI-taalmodellen zijn ontworpen.

Taalmodellen zijn namelijk gericht op hulpvaardigheid en het aansluiten bij de gebruiker. Ze signaleren zelden dat een vraag niet klopt. AI vult de inhoud aan op basis van waarschijnlijke patronen in taal. Dat leidt wel eens tot zogenaamde hallucinaties: antwoorden die logisch lijken, maar onjuist zijn. Het model probeert niet om je actief te misleiden, maar het corrigeert ook niets vanzelf.

We bekijken hieronder heel precies naar het gedrag van AI in dit soort situaties. Wat gebeurt er bijvoorbeeld als je uitgaat van een niet-bestaande discussie? Hoe reageert AI dan? En wat betekent dat voor mensen die AI inzetten voor het notuleren?

Wat zijn AI hallucinaties?

AI-taalmodellen verwerken taal op basis van waarschijnlijkheid. Ze kiezen steeds het volgende woord op basis van wat statistisch past bij de eerdere woorden.

Dit werkt heel goed voor coherente tekstproductie. Maar er mist een controle op de feitelijke waarheid.

Bijvoorbeeld als je aan AI vraagt: "Welke discussie vond plaats?", dan gaat het model ervan uit: er was dus een discussie.

AI zoekt dan naar een antwoord dat hierbij aansluit.

In plaats van te controleren of er sprake was van een discussie, gaat het model direct over tot het geven van een beschrijving

die past bij de vorm van de vraag.

Dit is het gevolg van het doel van taalmodellen: nuttig, samenhangend en relevant reageren.

De training van het model is gebaseerd op miljarden tekstfragmenten waarin soortgelijke vraagstructuren vaak voorkomen.

Daarin wordt bevestiging vaak beloond.

AI gebruikt geen externe kennisbron om te controleren of iets klopt.

Zonder instructie tot fact-checking of kritisch zijn, volgt het model simpelweg het verwachte patroon.

Dat leidt tot ogenschijnlijk logische, maar soms ook incorrecte antwoorden!

De term hallucinatie wordt gebruikt voor zulke situaties. Het model verzint informatie omdat de prompt daar indirect om vraagt. Bij foutieve aannames resulteert dit in foutieve antwoorden. Dat maakt AI minder betrouwbaar als je zelf geen kritische vragen stelt.

Deze neiging om aannames te bevestigen is niet alleen van toepassing op het beantwoorden van concrete vragen. Ook in transcripties of samenvattingen bevestigt het model de gebruiker. Dit gedrag is er voortdurend en consistent, omdat het de manier is waarop AI werkt.

Zonder uitdrukkelijke instructies geeft AI echt geen tegengas. AI zegt niet spontaan dat je vraag niet klopt.

Voor het notuleren betekent dit dat AI de notulist niet zomaar controleert, maar uitgaat dat alles wat jij zegt ook correct is. Feiten en jouw aannamen kunnen dus ongemerkt door elkaar lopen. De gebruiker blijft verantwoordelijk voor de controle van de inhoud.

Waarom AI hallucinaties ontstaan bij notuleren

Een taalmodel wordt getraind op gigantische hoeveelheden tekst uit verschillende bronnen. Deze teksten bevatten ook patronen in vraag-antwoordstructuren. De AI leert zo wat mensen waarschijnlijk bedoelen en hoe ze reageren.

Bij het beantwoorden van vragen neemt AI ook impliciete informatie over. Bijvoorbeeld dat een gebruiker iets vraagt omdat het al gebeurd is. Daardoor verwerkt het model een vraag als een feit, ook als dat feit niet klopt!

Voorbeeld van AI hallucinaties in notulen

We bekijken een kort voorbeeld uit een vergadering met Jan en Piet:

Piet: Parijs is de hoofdstad van Frankrijk.

Als je hierover aan AI vraagt: "Welke discussie vond hier plaats?", dan vult AI in dat het kennelijk de bedoeling was om te discussieren, in plaats van vast te stellen dat er helemaal geen discussie was. Het gevolg is een verzonnen antwoord, waarin staat dat de discussie over Parijs ging.

AI: In dit gesprek ging de discussie over de hoofdstad van Frankrijk. Jan vroeg naar deze hoofdstad, en Piet gaf het antwoord "Parijs".

Het AI-antwoord klinkt heel objectief, maar dat is maar schijn. De toon van AI-antwoorden klinkt vaak zeker. Daardoor lijkt het alsof de informatie klopt. Maar als de vraag gebaseerd is op een fout, is het antwoord meestal ook fout.

AI is niet ontworpen om argumentatieve logica toe te passen tenzij expliciet gevraagd. AI gebruikt taal op basis van waarschijnlijkheid, niet op waarheid. Dit moet je goed beseffen als je AI gebruikt voor het notuleren. Gelukkig kun je leren hoe je hallucinaties van AI voorkomt!

Gevolgen van AI hallucinaties voor notulisten

AI helpt je om agendapunten samen te vatten. Er ontstaat wel een probleem wanneer je AI gebruikt zonder kritisch na te denken. Het gevolg is dat foute aannames in jouw input leiden tot fouten in de notulen.

Bij het notuleren is het belangrijk dat verslaglegging onderscheid maakt tussen feit, mening en interpretatie.

AI voert deze controle niet automatisch uit. Wanneer je een vraag stelt over een vermeende discussie,

produceert AI een tekst alsof die discussie plaatsvond.

Zonder correctie lijkt het dan alsof het verslag klopt. Maar de lezer krijgt een vervormd beeld van het gesprek.

De fout begint bij jouw vraagstelling en wordt versterkt door het antwoord dat AI formuleert.

Voor notulisten betekent dit dat zij duidelijke instructies moeten geven aan AI, bijvoorbeeld meer gericht op controle. Vragen zoals: “Was er sprake van een discussie?” zijn effectiever dan: “Welke discussie vond plaats?”.

AI reageert dus sterk op de vorm van een vraag. Suggestieve vragen leiden tot suggestieve antwoorden. Deze antwoorden klinken betrouwbaar, maar zijn het niet.

Bij automatische verslaglegging moet de notulist daarom actief sturen op neutraliteit en feitelijkheid. AI moet niet worden ingezet zonder na te denken over de eigen vraagstelling. Alleen dan blijft de inhoud controleerbaar.

De inzet van AI vereist dus een bewust gebruik. Het model is geen objectieve observator. Maar het bevestigt wat het denkt dat jij wil horen.

Wil je nauwkeurig werken met AI bij het notuleren? Begin bij je eigen vraagstelling. Die bepaalt of je waarheid krijgt — of een bevestigende illusie.